Pour exploiter l’énorme potentiel social et économique de l’intelligence artificielle, il est capital d’en garantir un développement sûr, responsable et centré sur l’homme.

Considérée comme la prochaine révolution industrielle, l’IA est sur le point de presque tout changer dans nos vies. Mais la compréhension et l’atténuation des risques (dont une grande partie n’est pas entièrement comprise) est un sujet profondément complexe et difficile à appréhender.

Alors que les gouvernements du monde entier s’empressent de mettre en place des cadres pour identifier, classer et gérer ces risques, Intel, l’un des leaders mondiaux de la technologie des puces à l’origine de la révolution de l’IA, souligne l’importance de prendre en compte l’ensemble de l’écosystème.

L’un des moyens de s’assurer que cette technologie est utilisée pour faire progresser les objectifs sociétaux consiste à intégrer la sécurité au cœur même des outils logiciels et matériels utilisés pour créer de nouvelles applications d’IA.

Placer la sécurité et le développement éthique au centre du développement des produits réduit les risques liés aux biais, à la protection des données et au vol de propriété intellectuelle. Intel estime qu’il faut pour cela davantage que des compétences techniques : il est nécessaire d’adopter une approche globale des personnes, des processus, de la collecte de données et des algorithmes.

Les risques liés à l’IA sont de plus en plus discutés au niveau mondial par les gouvernements et les représentants de l’industrie. À mesure que les cadres réglementaires entrent en vigueur, nous devons absolument réfléchir à ce à quoi ils pourraient ressembler et appliquer ces règles au développement technologique dès maintenant. Nous nous posons en permanence la question de savoir où sont les risques et comment, en tant que multinationale, nous pouvons jouer le rôle qui est le nôtre,” explique Walter Riviera, ingénieur en machine learning chez Intel.

Afin d’identifier et d’atténuer les risques, et pendant que les technologies d’IA continuent d’évoluer, Intel a mis en place des groupes consultatifs composés de différents acteurs, comme des représentants de la société civile, des experts juridiques, des universitaires et des fonctionnaires. Ces groupes fournissent des conseils tout au long du développement des produits.

“Tout le monde avance rapidement dans ce secteur. Nous savons que nous devons collaborer pour faire en sorte que la croissance vertigineuse de l’IA contribue à l’amélioration de la société. C’est véritablement une question de collaboration internationale.”

En tant qu’acteur clé de l’écosystème de l’IA, nous voulons montrer au monde entier les avantages qu’elle peut apporter à la société et encourager son adoption,” poursuit Walter Riviera.

Cette approche du développement technologique a également permis d'obtenir des résultats tangibles en matière de développement de produits dans des domaines tels que l'informatique confidentielle, conçue pour protéger les données en cours d'utilisation grâce au cryptage, à l'isolation et à l'attestation. Cela inclut des technologies de sécurité basées sur le silicium telles que Intel® Trust Domain Extensions (Intel® TDX) et Intel® Software Guard Extensions (Intel® SGX).

Les scénarios dans lesquels ces fonctionnalités peuvent jouer un rôle critique comprennent la sécurité des données et la protection de la propriété intellectuelle, la confidentialité et la conformité, la souveraineté et le contrôle des données, et l'IA confidentielle. La sécurité activée par le matériel renforce la protection et permet à l'écosystème de mieux se défendre contre les menaces de cybersécurité modernes et en constante évolution.

Apprentissage fédéré : offrir des avantages tout en préservant la confidentialité

Si l’accent est mis sur l’IA générative (grands modèles de langage, ou LLM) comme ChatGPT, il existe de nombreuses autres façons d’entraîner et de déployer l’apprentissage automatique en vue d’améliorer les résultats de secteurs comme la santé.

En 2022, Intel Labs a collaboré avec la Perelman School of Medicine de l’université de Pennsylvanie dans le but d’appliquer une technique d’apprentissage automatique connue sous le nom d’apprentissage fédéré. L’objectif était ici d’améliorer la rapidité et la précision du diagnostic des tumeurs cérébrales.

L’algorithme, entraîné à partir de données de santé provenant du monde entier, a permis d’améliorer de 33 % l'identification des tumeurs cérébrales malignes. Il s’agit de la plus grande étude d’apprentissage fédéré dans le domaine médical à ce jour, avec un ensemble de données examinées provenant de 71 institutions des quatre coins du globe.

Mais qu’est-ce que l’apprentissage fédéré et comment cette approche s’applique-t-elle à l’apprentissage automatique ?

L’apprentissage fédéré est une approche de l’apprentissage automatique qui aborde le problème de l’accès aux données, par exemple lorsque des données sont protégées pour des raisons de confidentialité ou lorsqu’elles sont stockées sur un site distant, d’où le téléchargement n’est pas toujours possible.

Cette technique permet d’exploiter des données provenant de sources multiples et indépendantes, mais elle n’exige pas que leurs propriétaires, en l’occurrence les hôpitaux, les exportent ou les partagent. Cette approche protège la confidentialité et la propriété des données des patients dans les 71 institutions.

Les techniques d’apprentissage fédéré offrent à la société de nouvelles solutions à des problèmes complexes. Les machines traitent les ensembles de données comme des entités autonomes, ce qui permet au contributeur d’en conserver la propriété légale. Cela diffère notablement des méthodes traditionnelles de gestion des données, qui fusionnent les ensembles de données,” précise Walter Riviera.

“Il est remarquable de respecter les lois sur la confidentialité tout en exploitant la puissance de l’IA avec de vastes ensembles de données. Et bien qu’il faille parler de sécurité et de réglementation, les industries susceptibles de bénéficier de l’IA doivent comprendre ce que les applications peuvent accomplir en toute sécurité.”

Cette technique est déjà en vigueur dans les institutions financières et jouera un rôle majeur pour les villes et les environnements intelligents.”

Gouverner la technologie en interne : processeurs Intel et protection des données

L’élaboration de feuilles de route et le fait de disposer d’un cadre normatif clair pour le développement de produits, non seulement pour la protection des données mais aussi pour la propriété intellectuelle, est un élément essentiel de la stratégie de sécurité d’Intel.

Selon Intel, il est essentiel de mettre en place des comités consultatifs composés de différentes parties prenantes pour élaborer ce cadre, tout en tirant des enseignements de normes internationales et d’autres écosystèmes d’IA, ainsi qu’en anticipant les exigences réglementaires.

Nous sommes à l’écoute des questions que soulève la sécurité de l’IA et nous essayons de les traduire en langage technique lors du développement de nos produits. Nous croyons par ailleurs en une collaboration diversifiée avec des partenaires externes et des conseillers juridiques pour tout projet d’IA afin de garantir une vision globale de la gouvernance.”

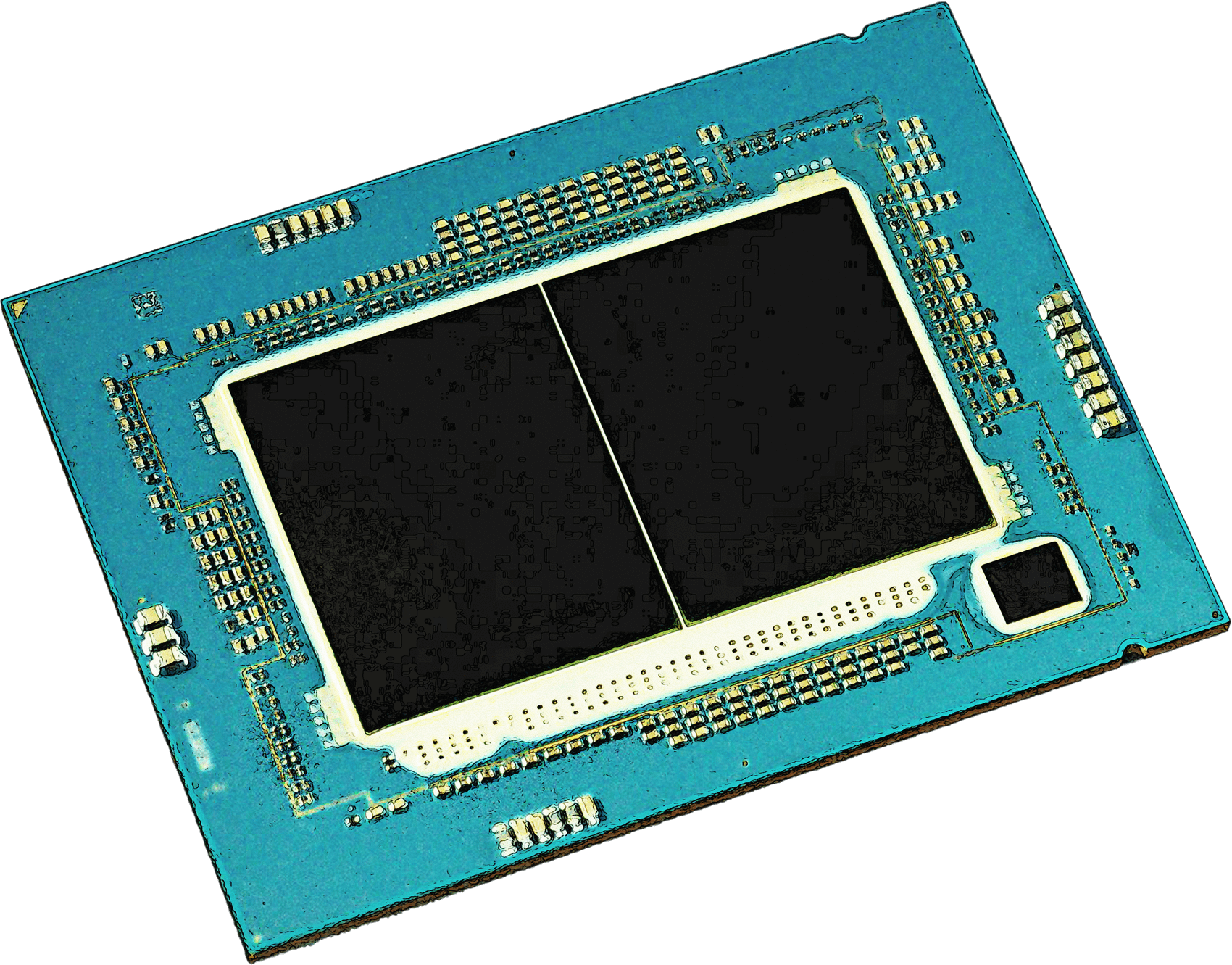

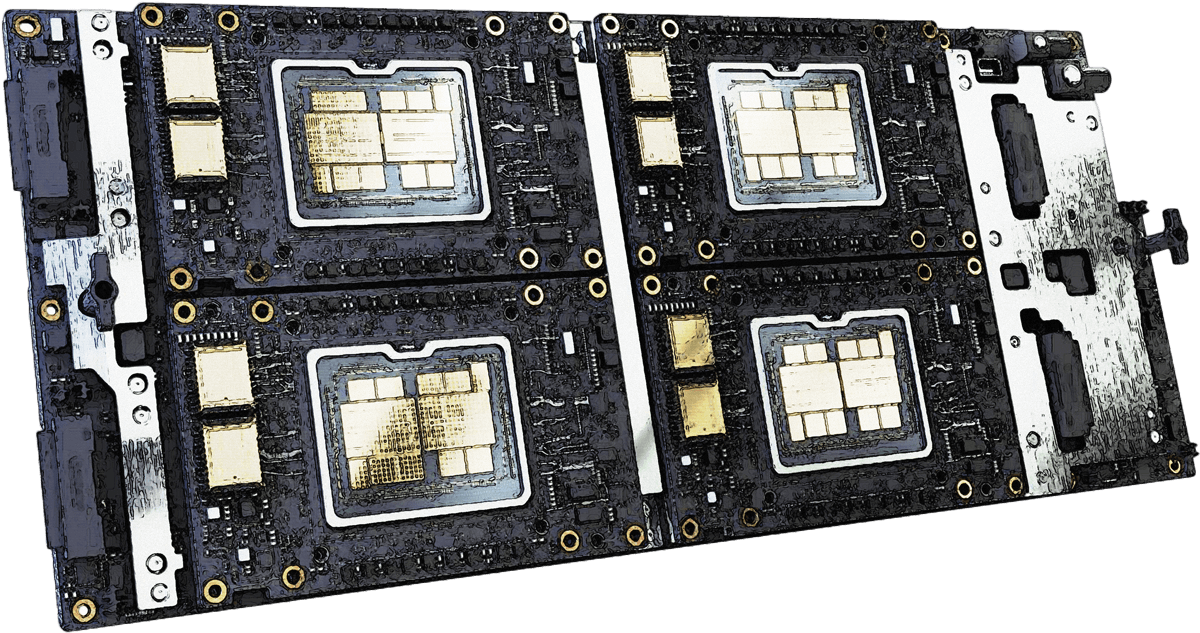

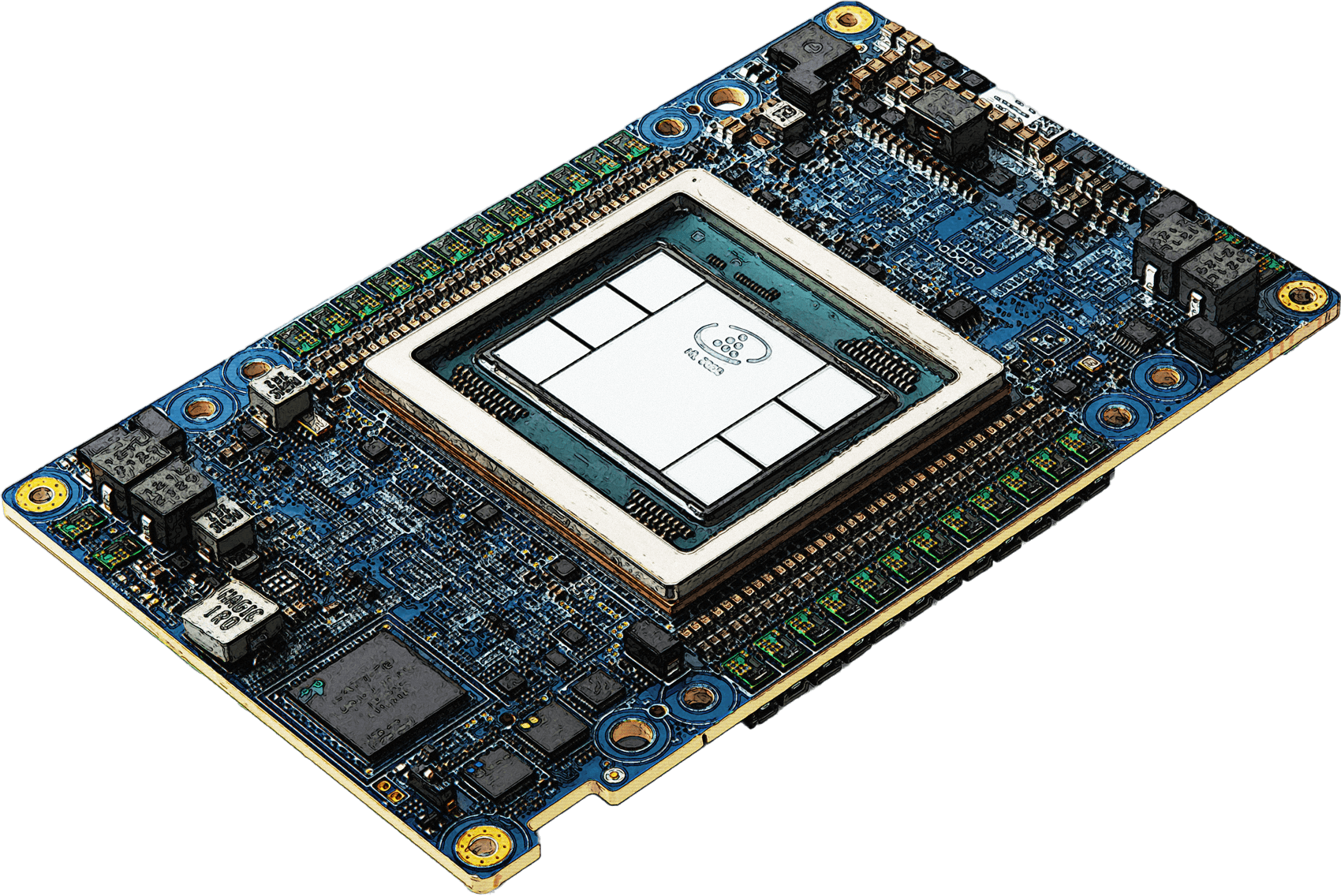

Le matériel de pointe d’Intel peut contribuer aux différentes étapes d’un pipeline d’IA. C’est par exemple le cas des processeurs Xeon dotés de caractéristiques spéciales comme l’Intel® Advanced Matrix Extensions (Intel® AMX) pour accélérer les charges de travail d’IA, de la GPU Max Series pour accélérer les charges de travail d'IA à la fois pour l'entraînement et l'inférence. La série Intel® Data Center GPU Max pour l'entraînement à l'IA, le HPC et les charges de travail graphiques ou la série Intel® Data Center GPU Flex, idéale pour le traitement des médias, le cloud gaming ou l'inférence visuelle de l'IA et l'infrastructure de bureau virtuel.

L'accélérateur d‘IA Intel Gaudi dédié au Deep Learning, idéal pour les charges de travail d'IA générative, comme le démontre le saut de performance de 2 fois sur GPT-3 avec l'adoption du logiciel FP8 pour Stable Diffusion - un générateur texte-image de deep learning - a une énorme puissance de calcul et est utilisé par certains des plus grands créateurs de l'IA.

Alors que de plus en plus d’entreprises de premier plan déploient des processeurs Intel pour l’IA, la vérification et la protection de l’intégrité, de la confidentialité et de l’authenticité des données deviennent aussi essentielles que les capacités techniques des processeurs.

Nous réfléchissons à la manière de protéger les données traitées par l’IA, ce qui inclut les menaces sur les données les plus sensibles (qui sont devenues de plus en plus avancées), synonymes de risques pour les entreprises, les organisations gouvernementales et les fournisseurs de cloud.”

“Il est essentiel de veiller à ce que des solutions de sécurité matérielles et logicielles soient intégrées à chaque étape pour les environnements cloud et d’entreprise : tous les acteurs de la chaîne de valeur sont responsables de l’utilisation équitable de l’IA.”

Une collaboration mondiale pour mettre l’IA au service du bien

Alors que l’intelligence artificielle continue d’affecter les secteurs du monde entier, la nécessité de collaborer et de se mettre d’accord sur les facteurs de risque et les moyens de gérer ces risques ne fera qu’augmenter.

Toutefois, l’appel à développer davantage de scénarios et d’applications qui profitent à toutes les strates de la société d’un point de vue économique et social est tout aussi important. C’est le cas pour les leaders de l’IA, comme les États-Unis, l’Europe et la Chine, mais aussi pour les pays en développement d’Afrique et d’Amérique latine.

“Les possibilités de l’IA sont infinies. L’enjeu réside dans le fait d’innover de manière responsable et de mettre en place les réglementations appropriées à chaque étape. La transparence est vraiment capitale et je pense que les principaux acteurs, comme les gouvernements, les groupes de réflexion et l’industrie, le comprendront.”

Plus il y aura d’exemples d’IA au service du bien déployés de manière sécurisée, plus nous verrons l’industrie (non seulement les grandes entreprises, mais aussi les PME et la société civile) en tirer réellement parti et créer un futur enviable.”